תוכן ענינים

Toggleהאינטליגנציה המלאכותית אינה עוד חזון טכנולוגי עתידי, אלא מציאות שמשנה את הדרך שבה ארגונים פועלים ומספרת לנו סיפור חדש על איך טכנולוגיה יכולה לעצב את העולם. כדי לתמוך ביישומים חזקים ופורצי דרך של AI, כמו למידת מכונה ועיבוד שפה טבעית, יש צורך בתשתיות אחסון שמותאמות לקצב המידע ההולך וגובר. **אדריכלות אחסון מתקדמת** היא לב העניין, ובתשתיות מותאמות נכונה נמצאים הפתרונות לאתגרים של גידול בנתונים, מהירות עיבוד ויעילות משאבים.

התפתחות הצרכים ביישומי AI

יישומי אינטליגנציה מלאכותית דורשים סביבות אחסון שמסוגלות להתמודד עם **נפח, מהירות ומגוון נתונים** חסרי תקדים. המשמעות היא שהמודלים של AI צריכים לגשת למידע במהירות וביעילות, לעיתים תוך פירוק נתונים מגוונים ממקורות רבים, כדוגמת מאגרי נתונים מסורתיים, אגמי נתונים (Data Lakes), והענן. אך הבעיה אינה רק הגישה לנתונים עצמם, אלא גם האופן שבו הם מעובדים והשימוש שבהם נתונים הללו מספקים בזמן אמת.

**ארכיטקטורות אחסון מסורתיות** שאינן תומכות בהיקפי המידע של AI נמצאות בנחיתות ברורה. כתוצאה מכך, עסקים שלא משקיעים בשדרוג הארכיטקטורה שלהם עשויים להיתקע עם צווארי בקבוק שמגבילים את ביצועיהם. לעובדה זו יש השלכות כלכליות מרחיקות לכת: לעסקים שמאמצים פתרונות מובנים ניתנת יכולת לחדש, לשפר את חווית הלקוח ולשפר תהליכים, בעוד שאחרים נותרים מאחור.

NVMe over Fabrics – הפתרון למהירות ויעילות

אחד הצירים המרכזיים לאדריכלות אחסון חדשנית הוא הטכנולוגיה של **NVMe over Fabrics (NVMe-oF)**. במילים פשוטות, מדובר בפרוטוקול שמאפשר גישה לנתונים במהירויות גבוהות מאוד ובזמן שיהוי נמוך במיוחד. למה זה חשוב? יישומי AI דורשים עיבוד של נפחים אדירים של נתונים תוך פרק זמן מינימלי – ועל כן, פרוטוקולים מסורתיים פשוט אינם מספקים.

שימוש ב-NVMe-oF מסייע ליצירת תשתית אחסון **גמישה ומדרגית** עם ביצועים חזקים יותר. לדוגמה, ביצועיה של מערכת למידה חישובית העוסקת בניתוח נתוני תמונה בזמן אמת יכולים להשתפר משמעותית הודות להפחתת זמן השיהוי בעת קריאת נתונים. בעידן שבו כל שנייה חשובה, המשמעות היא קיצור תהליכים עסקיים ושיפור יעילות תפעולית.

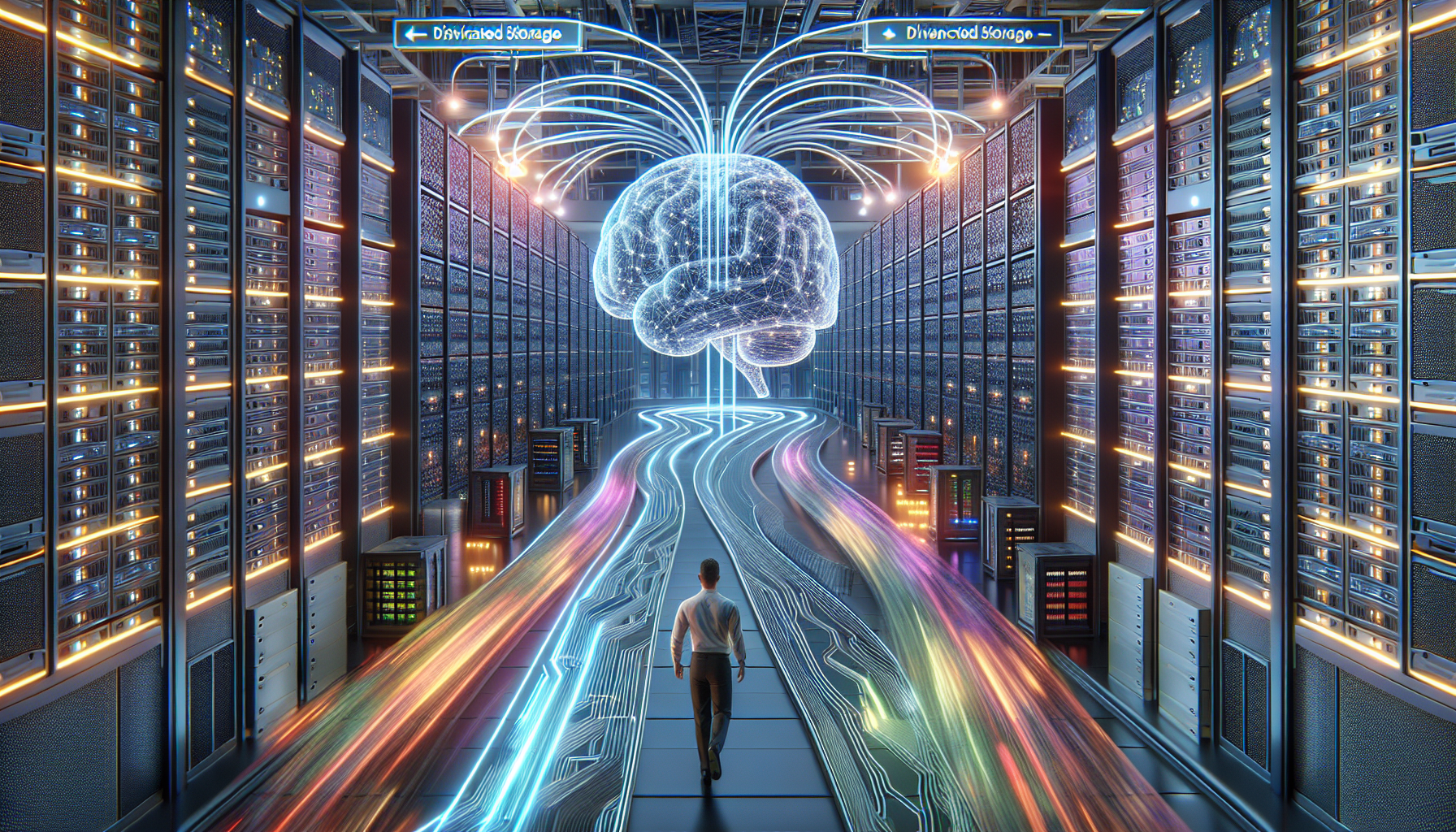

המעבר לאחסון מבוזר כמרכיב בסיסי

גל הטכנולוגיה מוביל ארגונים לעבור ל**אחסון מבוזר**, שבו האחסון והעיבוד פועלים בנפרד זה מזה. למה זה קריטי? פתרון זה מאפשר לארגונים להגדיל את היכולת האחסונית שלהם בלי להיות תלויים במגבלות המערכת הקיימת או ההשקעות הנוספות בשרתי עיבוד מוגבלים.

- דוגמה להצלחה: חברה המתמחה בניתוח רשתות חברתיות עבור תחזיות צרכניות שילבה פתרון אחסון מבוזר כדי לעמוד בדרישות המידע הדינמיות והמורכבות שלה. התוצאה הייתה גישה מהירה יותר לנתוני עתק והרחבת יכולות הניבוי עסקי שלה.

- יתרון כללי: אחסון מבוזר מאפשר לייעד משאבים בדיוק בהתאם לצרכים ללא כשלי יתר או חוסר בניצול משאבים.

חיבור בין התשתית לבין צרכים עסקיים

תכנון אדריכלות האחסון אינו רק החלטה טכנית – הוא החלטה אסטרטגית שנוגעת ישירות למטרות העסק. ארגונים מובילים לוקחים בחשבון את הדרישות העתידיות שלהם, ובונים תשתיות שמסוגלות להתרחב בהתאם למודלים העסקיים המשתנים. שילוב נכון של אחסון מבוסס NVMe-oF, עם גישה לאחסון מבוזר והתאמות למתודולוגיות AI, מבטיחים לארגונים עמידות ויכולת תחרותית לטווח הארוך.

אופטימיזציה של סביבות מקומיות ללמידת מכונה

כאשר מדברים על למידת מכונה, אנו מתייחסים לתהליכים שנמצאים במרכז הפעילות של יישומי אינטליגנציה מלאכותית. תהליכים אלו אינם רק "אלגוריתמים חכמים", אלא כוללים מערכות מורכבות המלוות בנתונים עצומים הנדרשים לעיבוד בזמן אמת. אחד האתגרים הגדולים ביותר בתחום זה הוא כיצד להקים ולהתאים **סביבות מקומיות** (On-Premises) כך שיוכלו לתמוך בדרישות הייחודיות של למידת מכונה בצורה **מהירה, גמישה ומשתלמת**.

יתרונות הסביבה המקומית מול הענן

בשנים האחרונות, עלות ושיקולי פרטיות מובילים ארגונים רבים לשקול מחדש את העדפתם לסביבות ענן בלבד, ולעיתים לחזור לפתרונות מבוססי סביבות מקומיות. אמנם הענן מציע יתרונות אדירים של גמישות וזמינות, אבל **המהירות, השליטה והחיסכון בעלויות שמציעות סביבות מקומיות ברוב המקרים משתלמים יותר כשמדובר בפרויקטים של למידת מכונה בהיקף נרחב**.

חשבו על ארגון שעוסק במשימות אבטחת סייבר מתקדמות ומפעיל מודלים ללמידת מכונה לזיהוי מתקפות בזמן אמת. בזמן שעבודה בענן יכולה להוסיף שכבת גמישות, הארגון עדיין צריך להבטיח שהנתונים הרגישים ביותר שלו ישארו מאובטחים ומבוקרים. במקרה כזה, אחסון מקומי המתממשק עם רכיבי חומרה מתקדמים יכול להפחית את זמן השיהוי של העברת הנתונים. כך, ניתן לעבד נתונים מהר יותר ולשדר תחושת ביטחון ושליטה מלאה.

שימוש בטכנולוגיות מתקדמות למקסום יעילות

כדי להפיק את המיטב מסביבות מקומיות עבור למידת מכונה, יש לשלב מערכות שמתוכננות במיוחד לדרישות האינטנסיביות של עיבוד נתונים. **מודולרים של נתונים בנפח גבוה**, מערכות אחסון מוגדרות תוכנה (Software Defined Storage), ופתרונות אחסון מבוססי NVMe הם רק חלק מהמרכיבים המרכזיים הדרושים להשגת ביצועים אופטימליים.

בנוסף לכך, השימוש בפתרונות **Direct Data Access** – גישה ישירה של המידע מהאחסון אל ה-GPU – הפך בשנים האחרונות ליתרון משמעותי בלמידת מכונה. דרך מערכות אלו, ניתן לעקוף את המעבד המרכזי (CPU) ובכך לחסוך משאבי מחשוב, להפחית את זמן העברת הנתונים ולשפר את היעילות הכוללת.

עיצוב תשתיות לאיזון בין עלויות לביצועים

על אף שהפתרונות המקומיים הם מבטיחים, יש לוודא שהם מתוכננים בצורה שתאזן בין הצרכים העסקיים לבין התקציב העומד לרשותכם. **תשתיות מודולריות** הן דוגמה מעולה לרעיון זה. הן מאפשרות להוסיף ולהסיר רכיבים (כגון דיסקים ומערכות אחסון נוספות) בהתאם לצורך, תוך מזעור ההשקעה הראשונית ושמירה על סקלאביליות עתידית.

- ניהול יעיל של משאבים: עיצוב מערכות שמאפשרות התאמת נפח האחסון למהירות ולכוח העיבוד הדרושים.

- פיזור עומסים דינמי: שימוש בכלים לניהול נתונים שמפזרים עומסי עיבוד בין מערכות GPU ו-CUDA בצורה מושכלת.

- התעדכנות טכנולוגית: השקעה באחסון מבוסס SSD ו-NVMe המספקים ביצועים מהירים ומקטינים את צריכת האנרגיה.

דוגמאות מיישום בפועל

כדי להמחיש את ההשפעה של אופטימיזציה לסביבות מקומיות, ניקח לדוגמה חממה טכנולוגית שמתמחה ביישומי למידת מכונה בתחומי בינה מלאכותית רפואית. אחד האתגרים המרכזיים שלה היה לנתח תמונות רפואיות (כגון MRI ו-CT) בנפחים גדולים ובעיכוב זמן מינימלי. על ידי הקמת סביבה מקומית מתקדמת, הארגון הצליח לקצר את זמן העיבוד ב-40% ולחסוך מעל 25% בעלויות הטיפול בענן.

דוגמה נוספת מגיעה מתוך תעשיית המדיה והבידור, שם מודלים ללמידת מכונה משמשים ליצירת אפקטים חזותיים מתקדמים בסרטים. באמצעות תשתית מקומית היברידית, התומכת גם בביצועים מהירים וגם באחסון רב-נפחי, אחד האולפנים הצליח לעמוד בלוחות זמנים צפופים תוך הפחתת זמן הרנדרינג הכולל ביותר מ-30%.

כלים ותוספים נלווים

ארגונים רבים אינם מודעים לכך שקיימים **כלי ניהול מבוססי תוכנה** שיכולים למקסם את הביצועים של הסביבה המקומית שלהם. כלים אלו מסייעים להפיק דוחות שימוש בנתונים, לנטר את ביצועי ה-GPU, ולבצע התאמות בזמן אמת.

| כלי | תפקיד מרכזי |

|---|---|

| TensorFlow Extended (TFX) | מעקב וביצוע בקרת מודלים בלמידת מכונה |

| Prometheus | מערכת ניטור לביצועי תשתית ושימוש בנתונים |

| Kubernetes | אוטומציה של פריסת משאבים לניהול עומסים |

השילוב בין **תוכנה מותאמת אישית**, פתרונות האחסון הנכונים, ואופטימיזציה של תשתית החומרה בסביבה המקומית יוצר יתרון משמעותי בארגון. יתרון זה לא רק מפחית עלויות, אלא גם מאפשר ביצועים גבוהים ברמה שמקדמת את תחרותיות העסק בשוק הגלובלי.

שילוב פתרונות אחסון מדרגיים עם האצת GPU

ככל שגדלות הדרישות ביישומי אינטליגנציה מלאכותית, כך עולה הצורך ביצירת שילוב מדויק בין כוח החישוב ליכולת האחסון. אחת המטרות המרכזיות בבניית תשתית מותאמת ל-AI היא לאפשר **שיתוף פעולה חלק בין רכיבי GPU מתקדמים לאחסון מדרגי ומהיר**, ובכך להאיץ את הביצועים ולהבטיח עיבוד נתונים בקצבים חסרי תקדים. השילוב הזה, כאשר מתוכנן בקפידה, הוא אבן יסוד בתשתיות החדשניות לתמיכה ביישומי AI מודרניים.

למה GPU חשובים בסביבת AI?

מעבדים גרפיים (GPU) שינו את חוקי המשחק בתחום האינטליגנציה המלאכותית. הם מתמחים **בעיבוד רב-מקבילי (Parallel Processing)**, ומאפשרים לחלק את עומס העבודה למספר רב של "משימות קטנות" שמתבצעות בו-זמנית. היכולות הללו, המותאמות במיוחד למשימות הנדרשות ב-AI, כמו אימון רשתות נוירונים, הופכות אותם לכלי החישובי האידיאלי למודלים חישוביים גדולים.

לדוגמה, במודל NLP (עיבוד שפה טבעית) הנתמך על ידי GPT-4, היכולת לעבד מיליוני פרמטרים בו-זמנית מאפשרת ליצור תוצאות מהירות ומדויקות הרבה יותר בהשוואה למעבדים מרכזיים (CPU) בלבד. אך גם היכולת המרשימה הזו תלויה בכך שה-GPU יקבל את הנתונים הדרושים לו במהירות ובאופן רציף – וכאן נכנס האחסון לתמונה.

האתגרים בחיבור בין GPU לאחסון

למרות היכולות המרשימות של GPU, אחת הבעיות הנפוצות היא יצירת **צווארי בקבוק** בתקשורת בין ה-GPU לבין מערכות האחסון. אחסון מסורתי, שאינו מותאם במהירות ובמדרגיות לדרישות ה-**AI**, עלול להאט את ביצועי המעבד הגרפי ולפגוע בתפוקות הארגון.

אתגרים מרכזיים:

- זמן שיהוי גבוה: כאשר לוקח זמן רב מדי להעביר נתונים ממערכות האחסון ל-GPU.

- תעבורת נתונים מוגבלת: מערכות אחסון מסוימות אינן מסוגלות להתמודד עם הקצב הנדרש לשידור נתונים בקנה מידה גדול.

- ניהול עומסים לא אופטימלי: חוסר תיאום בין כמות הנתונים לעיבוד לבין מה שה-GPU מסוגל לעבד בזמן נתון.

Direct Storage Access – איך לעקוף צווארי בקבוק?

אחת המהפכות המשמעותיות בחיבור בין אחסון למעבדים גרפיים היא טכנולוגיית **Direct Storage Access** שמאפשרת חיבור ישיר בין ה-GPU למערכות האחסון, תוך עקיפת ה-CPU. הגישה הישירה הזו מפחיתה משמעותית את זמן העברת הנתונים וממקסמת את תפקוד ה-GPU.

לדוגמה, במערכת המבוססת על **NVMe over Fabrics (NVMe-oF)**, ניתן ליצור תקשורת מהירה וישירה בין אחסון מבנה ל-GPU, תוך שימוש בפרוטוקולים מותאמים. השיפור אינו נעצר רק בזמן – אלא גם בביצועי הכוללים של התשתית כולה, עם הפחתת צווארי בקבוק ויכולת לטיפול בעומסים גבוהים עם פחות משאבים.

יישום פתרונות מדרגיים לשיפור ביצועי GPU

כדי להבטיח מיצוי מלא של היכולות הטכנולוגיות, יש לשלב פתרונות מדרגיים (Scalable Storage Solutions) המתוכננים לתת מענה לדרישות העתידיות של יישומי אינטליגנציה מלאכותית.

ארגונים רבים עושים כיום שימוש באסטרטגיות הבאות:

- שימוש באחסון מבוסס NVMe: פתרונות NVMe הופכים לבחירה המובילה בשל הביצועים הגבוהים וזמן התגובה המינימלי.

- הוספת שכבות אחסון מתקדמות: טכנולוגיות כמו Object Storage ותהליכים מוגדרי-תוכנה (Software-Defined Storage) למקסום גמישות ו-scalability.

- תיאום בין GPU ל-Storage: קינפוג מערכות כך שיכילו טכנולוגיית Tiering מתקדמת, המאפשרת שמירה של נתונים חמים קרוב ל-GPU.

לדוגמה, ארגון טכנולוגי מוביל שמתמחה בזיהוי פנים בזמן אמת שילב פתרונות אחסון האלה עם GPU כדי לשפר את זמן התגובה של מערכת הניתוחים שלו בכ-35%. שימור המידע החם קרוב למערכת המעבד תמך בתהליך הניתוח המהיר והבטיח מהימנות גבוהה לאורך זמן.

כלים לניהול עומסים והתאמה בזמן אמת

טכנולוגיות חכמות לניהול עומסים ולתכנון בזמן אמת הן חלק בלתי נפרד מהקמת מערכת תומכת AI. לדוגמה:

- NVIDIA GPUDirect Storage: מאפשר גישה מהירה מ-GPU למערכות אחסון על ידי יצירת מסלול תקשורת ישיר וממוטב.

- Apache Ignite: פתרון מבוזר לשמירת מטמונות נתונים המספק אחסון יעיל ונגישות גבוהה ליישומי AI.

- Kubernetes: אוטומציה של תהליכי ניהול משאבים לעיבוד אופטימלי של נתונים בהיקפים גדולים.

| כלים | יתרונות עיקריים |

|---|---|

| GPUDirect Storage | גישה ישירה לנתונים ללא שימוש ב-CPU, שיפור מהירות ויעילות |

| Apache Ignite | פיזור עומסים בעיבוד נתונים והגברת זמינות נתוני עתק |

| Kubernetes | ניהול דינמי של עומסים ושדרוג שרתים במידת הצורך |

באמצעות כלים אלו, ניתן למנוע עומסי יתר ולשפר את הקצאת המשאבים, תוך יצירת איזון מיטבי בין יכולות האחסון לביצועי ה-GPU.

בסיום, שילוב פתרונות אחסון מדרגיים עם האצת GPU אינו רק צעד טכנולוגי חשוב, אלא גם קריטי לפיתוח מיזמי AI בעידן המידע. ההבנה כי שילוב נכון של תשתית חומרה מעולה עם טכנולוגיות ניהול מתקדמות הוא המפתח להצלחה הופכת את התחום הזה לאחד המרתקים והמבטיחים ביותר בעולם הטכנולוגיה כיום – וזה רק הכיוון ההתחלתי.

עידן האינטליגנציה המלאכותית חולל שינויים תפיסתיים בגישה הארגונית לניהול מידע. אחד המפתחות המרכזיים להתמודדות עם הדרישות החישוביות והאחסונית המוגברות נעוץ באימוץ פתרונות **אחסון מבוזר**, המאפשרים לעסק לשבור את הקשר המסורתי בין משאבי עיבוד לכח אחסון תוך שיפור היעילות והתאמת המשאבים לצרכי זמן אמת. אך מעבר ליתרונות הבסיסיים, אחסון מבוזר פותח דלת לאופטימיזציה חדשה – הגדרה מחדש של ארכיטקטורה חכמה שתשמש כבסיס לחוויית AI בסטנדרט אחר.

מדוע אחסון מבוזר הוא הפתרון ל-AI בימינו?

כאשר מדובר ביישומי AI, הגמישות לכוונן ולהתאים פתרונות אחסון ללא צורך בעדכון רכיבי חומרה חופפת יוצרת יתרון ברור. **אחסון מבוזר מפריד את רכיב האחסון מיחידות העיבוד**, מה שמאפשר סקלאביליות גבוהה, חיסכון במשאבים וכן מינוף הפוטנציאל של GPU ו-Tensor Cores בכל הקשור לעבודה על מערכי נתונים רחבים ופיזור עומסי עבודה.

- יכולת הרחבה מתמשכת: אחסון מבוזר מאפשר התאמה דינאמית של נפח האחסון, כך שניתן להוסיף משאבים לפי מידת הצורך ללא שדרוג כולל של השרתים.

- גמישות משאבים: אחסון מבוזר מייצר סביבה בה ניתן להשקיע רק בנפח ובזמינות להם נדרש הארגון, בלי להוסיף משקל עודף על משאבי עיבוד קיימים.

- מניעת צווארי בקבוק: בזכות החלוקה החכמה, אחסון מבוזר יכול למנוע עיכובים הנוצרים מחוסר יכולת של רכיבי תוכנה חומרה לפעול באופן משולב.

איך אחסון מבוזר משפר עומסים בתהליכי למידת מכונה?

אחת הבעיות הנפוצות בסביבת AI היא צורכי עיבוד נתונים מאסיביים הקשורים לאימון מודלים ברשתות נוירונים. מערכי אחסון מבוזרים מציעים גמישות כשהם מאפשרים אימון רשתות מורכבות מבלי ליצור איטיות בתשתית שעלולה להאט את שגרת היום של המערכת כולה.

לדוגמה, חברה טכנולוגית המתמקדת בניתוח מידע רפואי (כגון תרגום דימות רפואי בזמן אמת) הצליחה לשלב **פלטפורמת אחסון מבוזר** עם GPUs כדי להשיג ביצועי עיבוד שנדרשו לבצע לומדות תוך התמודדות עם נפחי נתונים של טרה-בייטים. כתוצאה מכך, זמן העיבוד התקצר למחצית, ואותה גמישות אפשרה להתמקד גם בפרויקטים משניים נוספים.

דרכים ליישום אחסון מבוזר בסביבת AI

המעבר לאחסון מבוזר מחייב תכנון קפדני ומחשבה על הייחודיות של פרויקטים הקיימים והעתידיים תחת AI. הבסיס הוא שילוב טכנולוגיות מתקדמות בתשתית אחסון, אך גם אופטימיזציה מקיפה שכוללת את כל סביבת העבודה.

1. שימוש בטכנולוגיות אחסון מוגדרות תוכנה (SDS)

ארגונים החפצים ביכולת אחסון גמישה ומבוזרת מזהים את היתרונות שטכנולוגיות **אחסון מוגדר תוכנה (SDS)** מציעות. טכנולוגיות אלו מנותקות לחלוטין מתלות בחומרה ייעודית ומאפשרות לעסקים לפקח על אגמי נתונים ולעדכן את המידע תוך כדי עבודה בתשתית וירטואלית. השילוב הזה יוצר סנאריות שימוש דינאמיות במיוחד.

2. הטמעת פתרונות Object-Based Storage

אם היישומים שלכם דורשים זמינות נתונים למספר אזורים בו זמנית, פתרונות **Object Storage (אחסון מבוסס אובייקטים)** יכולים להוות פתרון יעיל. אחסון זה מתאים במיוחד ליישומים בעלי מטלות מוגדרות ופירוק נתוני עתק למקטעים קטנים. כך, ניתן לשלבם ב-RAM לניהול קריאה וכתיבה במהירות.

3. התאמה למתודולוגיות Tiering

ארגונים שוקלים כיום פתרונות Multi-Tier Storage – שיטה שבה נתונים "חמים" (Hot Data) נשארים באחסון הראשוני הקרוב ביותר לשרת, ונתוני "ארכיון" (Cold Data) מאוחסנים ברמות נגישות נמוכות יותר.

אילו תוצאות מציעות לנו מערכות אינטגרטיביות?

השימוש באחסון מבוזר בשילוב עם כלי בקרה ותיאום ייעודיים יוצר מערכות היברידיות שלומדות מהמשתמשים שלהם ומשלבות בינה מלאכותית כחלק מהניהול. מערכות אלו מציעות:

- תחזיות גלישה: דוחות נתונים מדויקים המציינים מגמות שיאפשרו אופטימיזציה בזמן אמת.

- שימור דאטה יעיל: מינימום אובדן נתונים באמצעות התאמה חכמה לעומסים.

- מניעת קריסות מערכות: עקב طراحی שמפיץ את המשאבים בזמינות גמישה.

בעתיד הקרוב, מערכות אלו יתחברו לטכנולוגיות מתקדמות כמו בינה רבודה ותבניות עיבוד IoT, ויאפשרו שליטה מלאה. הבחירה במעבר לאחסון מבוזר היא לא רק הכנה לעתיד חדש – אלא כבר חלק מהכאן ועכשיו הטכנולוגי הנדרש לעסקים מוכווני חדשנות.

איזון בין גמישות הענן לשליטה בתשתיות פרטיות

אחת השאלות המרכזיות שמלוות ארגונים בתכנון תשתיות ליישומי אינטליגנציה מלאכותית היא איך למצוא את שילוב האיזון האופטימלי בין **גמישות הענן** לבין **השליטה של סביבת on-premises**. עולם הענן מבטיח גישה מיידית למשאבים אדירים וזמינות בלתי פוסקת, אך עם זאת, השימוש בסביבות מקומיות מציע שליטה מעמיקה יותר, אבטחת מידע מוגברת ועלויות מותאמות יותר בטווח הארוך.

עלות מול ביצועים: כיצד לבחור נכון?

המעבר של עולם המחשוב לענן העניק לארגונים יתרונות אדירים בעלויות התפעול הראשוניות. במקום להשקיע מיידית בתשתיות מסיביות, עסקים יכולים לשלם על פי שימוש. עם זאת, כאשר מדובר ביישומי AI תובעניים, **עלויות השימוש במשאבי ענן יכולים להצטבר באופן משמעותי לאורך זמן**, בייחוד עם הגדלה משמעותית של נתונים ועליות בעומסי עיבוד.

לדוגמה, ארגון המפעיל מודלים של למידת מכונה בנפחי נתונים אדירים עלול למצוא עצמו בתקציבים בלתי נשלטים בעת מעבר מתשתיות on-premises לתשתיות ענן בלבד. הפתרון? **שילוב גישה היברידית.** גישה זו מבטיחה שהנתונים הנפוצים והמיידיים יאוחסנו בסביבה מקומית מהירה וזולה יותר, בעוד שבמקרים של צורך ב-scalability, ניתן לגשת לשירותי הענן.

מתי כדאי להעדיף סביבה מקומית?

למרות יתרונות הענן, ישנם מקרים ברורים בהם סביבות on-premises עולות על טכנולוגיות הענן במבחן התוצאה. לדוגמה:

- אבטחת נתונים: יישומים רגישים במיוחד, כמו ניתוח מידע רפואי או מחקר ביטחוני, מחייבים שליטה מוחלטת על מיקום הנתונים, מי גולש אליהם וכיצד הם נשמרים.

- שיהוי נמוך: כשהדרישות לעיבוד בזמן אמת קריטיות, כמו במערכות זיהוי פנים או בזמן עיבודי נתונים בבינה מלאכותית בתחומי מסחר בזמן אמת, כל מיקרו-שנייה חשובה. בסביבה מקומית, ניתן להפחית זמני השיהוי למינימום האופטימלי.

- חיסכון לטווח ארוך: עבור פרויקטים ארוכי טווח, שבהם כמות הנתונים צפויה לגדול משמעותית ותשתיות הענן יהפכו ליקרות מידי, אחסון מקומי יכול להיות השתלמות חכמה.

השפעה על ביצועי AI

אינטליגנציה מלאכותית מושפעת רבות ממהירות השליפה והעיבוד של מאגרי הנתונים. שימוש לא נכון בתשתיות אחסון עלול להאט את הביצועים של יישומים קריטיים. לדוגמה, חברה שמתמחה בניהול שרשראות אספקה מבוססות AI צריכה לבצע תחזיות רגעיות המבוססות על נתוני זמן אמת. אם תיווצר תלות מוחלטת בענן ובמקביל יתמודדו עם עיכובים עקב עומסים או בעיות רשת, ביצועי ה-AI יפגעו ואף עלולים לגרום לארגון הפסדים משמעותיים.

במקרה של **מודל היברידי**, נתוני זמן אמת יכולים להיות מאוחסנים ומנוהלים בתשתיות המקומיות, בעוד שפעילויות ניתוח משלימות או מאגרי מידע ארכיטיביים אחרים יכולים להמשיך להתנהל בענן.

המפתח: גישה היברידית חכמה

המגמה הנוכחית בעולם הארגוני היא מעבר לזירות היברידיות, שמשלבות בין אחסון בענן לאחסון מקומי. הנה כמה נקודות חשובות שיסייעו להבטיח שבחירה זו תהיה האידיאלית לארגון שלכם:

- קביעת מדיניות אחסון: חשוב מאוד להבדיל בין נתונים חמים (לשימוש אקטיבי) לבין נתוני ארכיון וקריירים אחרים. לפי חלוקה זו קובעים מה יאוחסן בענן ומה במקומי.

- שימוש בפרוטוקולים של שכבת דיווח: על מנת להבטיח תקשורת רציפה בין הענן למקומי, ניתן לשלב כלים אוטומטיים כמו Kubernetes או Microsoft Azure Arc לניהול דינמי של עומסים.

- הערכת התשתיות המקומיות שלכם: אם הסביבות המקומיות אינן מותאמות לדרישות AI המודרניות (לדוגמה, אין תמיכה ב-NVMe או בגישה לסביבות GPU), ייתכן שיהיה צורך לחשב מחדש האם התקציב מצדיק שדרוגים חיוניים.

דוגמאות מעשיות

חברה בתחום הפינטק המתמחה בניתוחי שוק בזמן אמת נאלצה להתמודד עם זמני גישה למידע בענן שהיו איטיים מדי עבור מנועי למידת המכונה שלה. באמצעות שילוב פתרון היברידי, העבירה החברה תהליכי ניתוח ראשוניים למערכות מקומיות – מה שהפחית את זמן עיבוד הטרנזקציות ב-60%. יתרה מכך, שילוב גישה דינאמית איפשר לה לנצל זמני "שפל" בעומס להסטת אחזקת נתונים מלאה למערכות ענן.

דוגמה אחרת מגיעה מחברת ביוטק שנדרשה לנתח נתונים מריצוף גנטי במעבדות ענקיות ברחבי העולם. על ידי בניית משאב מבוזר שמשלב בין אחסון ענן לתשתית GPU מקומית, הצליחה החברה להפחית את זמן האנליזה הכוללת ב-45% תוך שיפור זמינות המידע בין סניפים.

טכנולוגיות מובילות לחיבור ענן וחומרה מקומית

כמה מהכלים והפתרונות הבולטים שיכולים לעזור בשילוב מערכות הענן והמערכות המקומיות כוללים:

| טכנולוגיה | יתרונות |

|---|---|

| VMware vSphere | מערכת לניהול תשתיות וירטואליזציה היברידיות |

| Google Anthos | ניהול יישומים בענן ובמקומי מתוך פלטפורמה אחת |

| Microsoft Azure Stack | פתרון של מיקרוסופט לפריסת יכולות ענן בחומרה מקומית |

באמצעות ההטמעה של פתרונות אלו, ארגונים יכולים להבטיח ניצול יעיל של משאבי הענן והמקומי, תוך מקסום ביצועים, שליטה בעלויות ויצירת גמישות המבוססת על צרכים משתנים.